반응형

활성화함수

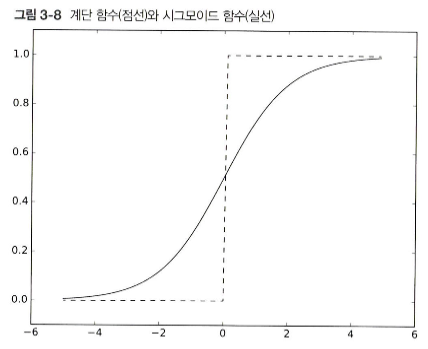

시그모이드 함수

- $h(x) = 1/1+exp(-x)$

- 시그모이드와 계단함수의 차이점 : 매끄러움. 계단함수는 0 or 1의 값을 돌려주지만, 시그모이드 함수는 0과 1 사이의 연속적인 값을 가지고 있음.

ReLU 함수

- Rectified linear Unit

- 입력이 0 이상이면 값을 그대로 사용, 0 이하면 0을 출력

def relu(x):

return np.maximum(0, x)

*배열의 차원 수 : np.ndim() 함수로 확인 가능

반응형

'AI > DeepLearning' 카테고리의 다른 글

| [밑바닥부터 시작하는 딥러닝1] 밑딥 스터디 CH6 정리 (4) | 2024.07.25 |

|---|---|

| [밑바닥부터 시작하는 딥러닝1] 밑딥 스터디 CH5 정리 (1) | 2024.07.24 |

| [밑바닥부터 시작하는 딥러닝1] 밑딥 스터디 CH4 정리 (1) | 2024.07.24 |

| 딥러닝 개념정리 (0) | 2023.04.13 |

| [개념]선형(linearity) (0) | 2023.04.09 |

댓글